ChatGPT? A legnagyobb hazugság

Mindenki hirtelen chatGPT-ről beszél.

A chatGPT a legnagyobb hazugság – mármint az, amit a “tudós urak” állítanak vele kapcsolatban.

NEM róla, hanem vele kapcsolatban. Ez amúgy nem először fordul elő.

A legnagyobb kérdés ugyanis (még a kérdést is nehéz jól feltenni, megfogalmazni): mennyivel “okosabb” chatGPT mint egy ember?! És: chatGPT egy egyszerű gép, vagy pedig valójában is intelligens?

Az “okos urak” egybehangzó állítása – hogy a chatGPT egy egyszerű statisztikai modell, ami bizonyos bemenetek (amit írok neki, kérek tőle) alapján ad bizonyos kimeneteket (válaszokat). Ezért aztán valójában nem értelmes, nem “okos” – emberi mércével mérve semmiképp.

És ennyi.

Nos – ebben az állításban becsomagolva rejtőzik egy hatalmas hazugság. Azért így írom, mert az, hogy mi az “igazság” – azt senki sem tudja, de mégis – hivatkoznak rá.

De ne rohanjunk ennyire előre.

Rövid – 1 perces – összefoglaló azoknak, akik nem tudják mire jó a chatGPT

Aki nem tudná mi ez: egy szoftver, amibe beírsz kérdéseket, kéréseket – és teljesíti. Egyelőre nem a fizikai világban, de ahhoz is közeledünk.

Miket is tud jelenleg a chatGPT?

-Teljesen értelmes szövegeket tud írni, rövid pár soros, mondatos utasítás alapján

-A szöveg formátumát is megválaszthatjuk

-Hosszú szövegeket tud összesíteni, rövid formátumban

-Beszélgetni tud, szinte tetszőleges témáról

-Fordítani tud egyik nyelvről a másikra

-Szoftver kódot is ír – szoftver kódot, ami használható, fordítható

Mitől izgalmas mindez?

- Mert a “hivatalos” internet egy jelentős részét feldolgoztatták már vele. Azaz sokat “tud”.

- Többnyelvű: a fentieket jelenleg 95 nyelven tudja teljesíteni.

- Szövegkörnyezet: ismeri, érti a szöveg környezetét – azaz “emlékszik”, hogy 3 bekezdéssel előrébb mi hangzott el, és ennek megfelelő válaszokat ad

Rövid – 1 perces – összefoglaló azoknak, akik nem tudják hogyan jött létre

Egy mondatban: képzés emberi visszajelzés alapján (Reinforcement Learning from Human Feedback (RLHF)) – azaz:

- Összegyűjtöttek nagyon sok szöveges adatot az internetről sok helyről és ezeket beöntötték egy egységes struktúrába és helyre és raktak “alá” brutális számítási kapacitást

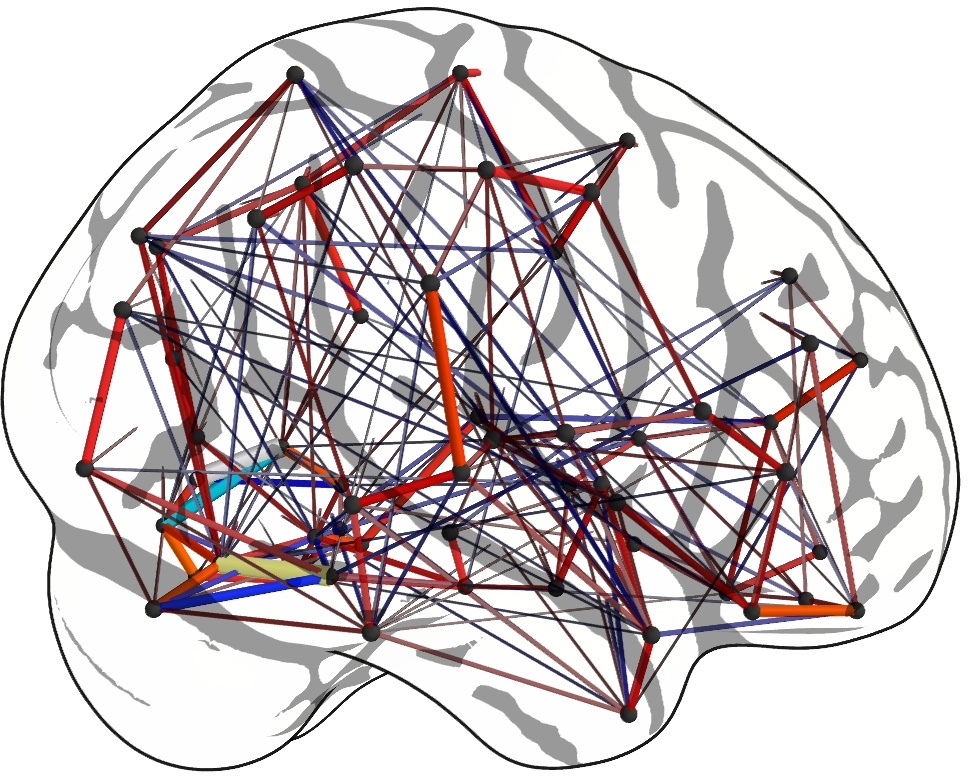

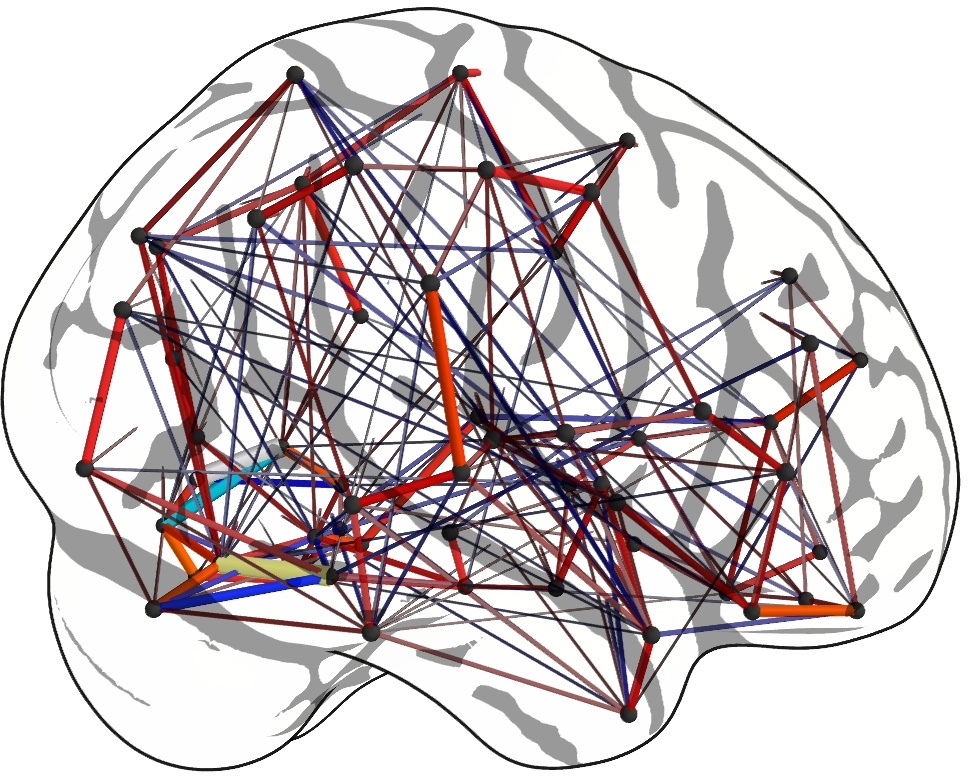

- Az egységes struktúra alapja egy olyan “hálózat” aminek az egyes pontjai és az élei is számok (súlyok, valószínűségek) – kb. mint az emberi agyban. Neuronok vannak, amelyek között kapcsolatok jönnek létre vagy szűnnek meg.

- ebben a hálózatba küldenek be kérdéseket – és kapnak válaszokat – majd a válaszokat egyrészt a hálózat maga is tudja osztályozni (saját maga “játszik”, tanul: megpróbálja kitalálni egy kapott szövegre, amiből részleteket töröl, hogy a kitörölt részlet helyén mi lehet – az, amelyik esetben kitalálja, azt a kapcsolatot megtartja (a súlyt növeli) amelyiknél nem vagy nem teljesen jól találta ki azt a kapcsolatot törli vagy a súlyt csökkenti – ezt csinálja meg pár száz milliárd paraméterre

- Hogy mit is tanul a modell? Egyszerű: a kapott szövegben benne van, hogy Boci boci tarka -> majd kitaláltatják vele, hogy ez a bemenet “Boci boci …” és itt az utolsó szót kell, hogy kitalálja. Ha azt adja, hogy “tarka” azaz ez egyezik a megoldással, akkor azt a paramétert (súlyt) növeli, ha azt adja, hogy “barna”, akkor csökkenti, ha azt adja, hogy “kék” akkor törli.

- Majd miután ezen a saját-képzésen keresztülment, jön az emberi visszajelzés alapján való tanulás. Itt emberek választják ki, hogy a megadott válaszok közül melyik a helyesebb. A modell ebből is “tanul” (ezt hívják ún. Reinforcement Learning-nek – megerősítéses tanulás-nak).

Hol van itt a hazugság?

Nos – a magukat “okos”(nak tartó) emberek (nem, semmi bajom az “okos”-okkal. Egyáltalán semmi, de semmi. Örülök, hogy vannak, sőt, magamat is bizonyos mértékig közéjük sorolom: imádom a számokat, a gondolkodást, a logikus gondolkodás jópár válfaját – de nem szeretem azt állítani, hogy már “mindent tudunk” a világról (és a tudomány mindent tud a világról) és hogy a többiek csak “kis butus”-ok, akik “ezt sem tudják”) – szóval a magukat “okos”-nak tartó emberek azt állítják:

“Ez csak egy statisztikai modell”

“Nem tud magáról, nem olyan, mint az emberi agy”

“Nincs benne semmi olyan, mint az emberben”

és még sorolhatnám.

Nos.

Azon túl, hogy halvány gondolataink, ismereteink vannak arról, hogyan működik az emberi agy, és mely részei milyen funkciókért felelnek – nem tudjuk, hogy mi az emberi elme.

Mitől van – tudat.

Mitől és honnan van – memória.

Vannak róla ismereteink – de ezek az ismeretek messze nem teljesek.

Az emberi agy és a chatGPT-féle modellek

Az emberi agyban van kb. 120 milliárd (10 a 11-ediken) neuron. Ezek a csomópontok, mint a nagy nyelvi (és más) mesterséges-intelligencia-modellekben.

És – vannak közöttük kapcsolatok (ún. szinapszisok) – amelyek kialakulnak, megszűnnek. Ezekből van kb. 10 a 15-en (ez kb. 1 000 000 milliárd, azaz egymilliószor egymilliárd).

Minden egyes szinapszisban van kb. 10 000 – 100 000 ún. kapcsoló. Ezek a szinapszisok súlyai.

Azaz az agynak lehet 10 a 15-en x 10 000…100 000 állapota.

Egy jó kis beszélgetés a témáról itt.

Ebből csak egy mondat: “We don’t know how a brain produces a thought, I don’t even know how I would define what a thought is”

Azaz: “Nem tudjuk, az agy hogyan állítja elő a gondolatot, azt sem tudjuk, hogyan definiáljuk, mi egy gondolat”

Nem nagy meglepetés, hogy a mesterséges-intelligencia-modelleket az agy feltételezett alap-modellje alapján készítették.

Ez ellentmondásosnak tűnhet, hiszen leírtam, hogy “nem tudjuk, hogyan működik az agy” – akkor hogyan készítenek ez alapján modellt?

A válasz egyszerű: “nem tudjuk hogyan működik az agy” azt jelenti: “nem tudjuk, mitől működik ez az egész”. Azaz az alap-építő-elemeket már látjuk. De mivel rengeteg van belőlük (viccesen írhatjuk: tényleg, ésszel felfoghatatlanul sok), ezért nem tudjuk, nem értjük, hogy együttesen mégis hol, hogyan születnek a gondolatok.

És akkor megérkeztünk a legnagyobb hazugsághoz: merthogy a mesterséges-intelligencia modellekkel ugyanez a helyzet. Nem értjük, hogy jön ki az eredmény. Csak azt látjuk, hogy jól-rosszul: működik.

Jelenleg néhány 100 milliárd (10 a 11-ediken) számú paraméter (kapcsolat) van bennük.

Ez kb. 10000-ed (egy tízezred) része az agyban található kapcsolatok számának.

Láthatjuk, hogy nem vagyunk messze. Persze itt minden 10-es ugrás exponenciálisan növeli a számítási igényeket. De: folyamatosan születnek az újabb és újabb modellek, amelyek éppen hogy csökkentik a számítási igényeket.

Azaz: fizikailag, strukturálisan vizsgálva, összehasonlítva az emberi agyat a mesterséges-intelligencia modellekkel: látható, hogy paraméter-számban még le vannak maradva, de ez sem lesz sokáig így.

Mi van amikor – a mesterséges-intelligencia-modell: hazudik, hallucinál?

Hallucinálásnak hívják azt, amikor a modell olyan választ ad, ami egy embernek nyilvánvaló butaság – és egy ember számára látszik, hogy véletlenszerű a válasz.

Bizonyíték-e ez arra, hogy a mesterséges intelligencia-modell: nem “gondolkodik”?

Nos – aki adott már emberként rossz választ – válaszoljon magának erre a kérdésre.

Merthogy csak erre alapozva nem lehet “megfogni” a mesterséges intelligenciát.

Ha “neki” az a dolga, hogy válaszoljon – válaszolni fog. Az általa ismert “tények”, súlyok (=paraméterek) alapján.

És: ha nem ismeri a tényeket – akkor is válaszol. Ismerős ez valahonnan? Mi emberek – van, hogy ugyanilyenek vagyunk. Statisztikai válasz-adó gépek.

És akkor: egy kis – filozófia, ami nem az, hanem hívhatjuk tudománynak is

És – a továbbiakat nem tudom számokkal alátámasztani, csak én ezt bevallom, a “tudósok” ezt nem vallják be.

Merthogy: a megérzésem szerint az agy is csak – egy statisztikai gép.

Bemenetekre ad – kimeneteket. Amit mi – tudatként érzékelünk.

Rengeteg, a tudattal és a döntésekkel foglalkozó könyv ír ugyanerről: hogy valójában az agyunk meghoz döntéseket (“tudatalatti”) és a tudatos agy már csak ezeket a döntéseket ismeri fel.

Azaz: valamilyen emlék-csoportok alapján (amik a tudattalanban vannak raktározva) a tudatalattink meghoz egy döntést – amit aztán érzések útján kommunikál a tudatos agy-részünkkel, ami azt “gondolja”, hogy tudatosan dönt.

Erről szólnak a reklámok. A politika. A párválasztás. A munkahely-választás.

Azaz: tudjuk hogy reggel mi alapján döntjük el: szundítsunk-e még 10 percet?

Tudjuk?!?

És: a tudattalan pedig honnan veszi a döntést? Hát a múltbeli tapasztalatokból.

Azaz ha belegondolunk: az agyunk is “csak” egy statisztikai gép, ami múltbeli tapasztalatok alapján hoz véletlenszerű döntéseket.

Hogy lehet akkor, hogy az emberek alapvetően kiszámíthatóak és mondjuk nem megyünk át véletlenszerűen a piroson? Hát úgy, hogy a tudatalattinkban felhalmozott tapasztalat – alapvetően azonos. És: attól függően, ahol felnövünk, kapunk további kulturális normákat. Így pl. templomban nem hangoskodunk. Felhevült testtel jó eséllyel nem ugrunk a vízbe (hacsak nincs valami másik norma, ami erre késztet minket). És így tovább.

Zárszó – avagy: mikor fogjuk tudni, hogy a mesterséges intelligencia tudatra ébredt?

Emberi aggyal: soha.

Merthogy: az agy és az erre épülő tudatunk olyan komplexitású, hogy emberi aggyal, ésszel – nem megfejthető.

Számítógépes modelleket építhetünk rá – amiknek a kimenetei majd összevethetőek az “embertől elvárható” kimenetekkel, de ez is “csak” statisztika lesz – ez esetben a kimenetek %-os egyezését tudjuk ellenőrizni. Azaz azt, hogy a gép – egy helyzetben úgy válaszol, ahogy azt embertől elvárnánk.

Szubjektív módon meg már: most is tudjuk. Van aki azt gondolja, a gép tudatra ébredt, van aki azt gondolja, nem.

Aki mást állít: hazudik. Nem nekem – saját magának.

Miben segítenek nekünk ezek az mesterséges-intelligencia-modellek? Megjegyzés

Megtanulni, mi tesz minket emberré. Tudjuk? Igazán? Majd megtudjuk. 🙂

Mielőtt megkérdezik többen: azt gondolom-e, hogy tudatra ébredt az AI?

Nem tudom. Mert: ahogy írtam fenn: nem tudjuk, mi a tudat.

Amit már írtam Facebook-on:

ChatGPT? The biggest lie

Everyone is suddenly talking about chatGPT.

chatGPT is the biggest lie – that is, at least what “scientists” claim about it.

NOT about it, but relating to it. This is not the first time this has happened.

The most important question is (but please note that even the question is difficult to ask and to be formulated well): how much “smarter” is chatGPT than a person?! Is it? And: is chatGPT a simple machine or is it actually intelligent?

The unanimous statement of the “smart guys” is that chatGPT is a simple statistical model that produces certain outputs (=answers) based on certain inputs (=what ask from it). Therefore, it is neither actually sensible, nor “smart” – by human standards, for sure.

And that is all.

Well – wrapped in this statement there lies a huge lie. I write it this way because no one knows what the “truth” is, but they still keep on referring to it.

But let’s not rush ahead so much.

Short – 1 minute – summary for those who don’t know what chatGPT is good for

For those who don’t know what chatGPT is: a software in which you enter questions and requests – and it fulfills them. Not in the physical world yet, but we’re getting close to the latter one, as well.

What can chatGPT currently do?

-Can write completely meaningful texts, based on short, one-sentence instructions

-You can also choose the format of the text

-It can summarize long texts in a short format

-It can chat with you about almost any topic

-Can translate from one language to another

-It also writes software code – software code that can be used and compiled

What makes all this exciting?

- Because a significant part of the “official” internet has already been processed with it. In other words, he “knows” a lot.

- Multilingual: you can currently complete the above in 95 languages.

- Context of the text: knows and understands the context of the text – i.e. “remembers” what was said 3 paragraphs earlier and gives corresponding answers

Short – 1 minute – summary for those who don’t know how it was created

In one sentence: training based on human feedback (Reinforcement Learning from Human Feedback (RLHF)) – i.e.:

- They collected a lot of text data from the Internet from many places and poured it into a unified structure and place and put brutal computing capacity “under” it

- The basis of the unified structure is a “network” whose individual points and edges are also numbers (weights, probabilities) – quite similarly as it is in the human brain. There are neurons between which connections are made or destroyed.

- questions are sent to this network – and they receive answers – and then the answers can be classified by the network itself (as it “plays” by itself, it learns: it tries to guess what could be in the place of the deleted part – if it figures it out well, it keeps that connection (increases the weight); in the case that it didn’t figure it out at all or didn’t figure it out quite well, it deletes that connection or reduces the weight – and does it for a few hundred billion parameters

- What does the model learn? It’s simple: the received text contains “The Itsy Bitsy Spider” -> then it guesses that based on this input “The Itsy Bitsy …” what the output is. If it enters “Spider”, i.e. it matches the solution, then it increases that parameter (weight), if you enter “Spade”, it decreases the weight, if it enters “Cat”, it deletes the connection.

- Then, after going through this self-training, there comes learning based on human feedback. Here, people choose which of the given answers is more correct. The model also “learns” from this (this is called Reinforcement Learning).

Where lies the lie?

Well – the “smart guys” (no, I have no problem with “smart guys”. Nothing at all, but nothing. I’m glad that they exist, in fact, I count myself to some extent amongst them: I love numbers, thinking, ways of logical thinking – but I don’t like to claim that we already “know everything” about the world (or that “science knows everything about the world”) and that the “all others” are just “little idiots” who “don’t know this or that either”) – so these “smart guys” claim:

“This is just a statistical model”

“It is unlike human mind or brain”

“There is nothing in it that can be found in humans”

and so on.

Well.

Beyond the fact that we have vague thoughts and knowledge about how the human brain works and which parts of it are responsible for which functions – we do not know what the human mind is.

Where consciousness is coming from.

What and where memory is in it.

We have knowledge about it – but this knowledge is far from complete.

Human brain and models like chatGPT

The human brain has approx. 120 billion (10 in 11) neurons. These are nodes, as in the large language (and other) artificial intelligence models.

And – there are connections between them (so-called synapses) – which form and cease. Of these there are approx. 10 out of 15 (that’s about 1,000,000 billion, i.e. one million times one billion).

Each synapse has approx. 10,000 – 100,000 so-called switches. These are the weights of the synapses.

That is, the brain can have 10 out of 15 x 10,000…100,000 states.

.

A good and nice brief discussion about what we know about the human brain today is here.

Just one sentence: “We don’t know how a brain produces a thought, I don’t even know how I would define what a thought is”

It is not a big surprise that the artificial intelligence models were created based on the assumed basic model of the human brain.

This may seem contradictory, since I described that “we don’t know how the brain works” – so how do you make a model based on this?

The answer is simple: “we don’t know how the brain works” means: “we don’t know what makes it all work”. That is, we can already see the basic building blocks. But since there are so many of them (we can write it funnily: really, un-understandeably many), that’s why we don’t know, we don’t understand where and how thoughts are born.

And then we arrived at the biggest lie: because the same is the case with artificial intelligence models. We don’t understand how the result comes out of them, are born inside of them. We only see that, for better or for worse: it works.

Artifical intelligence models currently have some 100 billion (10 on the 11th) parameters (connections).

This is approx. 10,000th (one ten thousandth) of the number of connections in the brain.

We can see that we are not far away. Of course, every jump of 10 here exponentially increases the calculation requirements. But: newer and newer models are constantly being created, which just reduce the calculation requirements.

That is: physically and structurally examined, comparing the human brain with artificial intelligence models: it can be seen that they are still lagging behind in the number of parameters, but this will not be the case for long.

What happens when – the artificial intelligence model: lies, hallucinates?

It’s called a hallucination when the model gives an answer that is obviously stupid for a human reader – as such for a human the answer appears to be random.

Is this proof that the artificial intelligence model: does not “think”?

Well – whoever has already given a wrong answer as a person – answer this question for yourself.

Because artificial intelligence cannot be “judged” based on this alone.

If “its” job is to answer – it will answer. Based on the “facts” it knows, weights (=parameters).

And then: a little – philosophy, which is not, but can also be called science

And – I cannot support the rest with numbers, I only admit this, while some of the “scientists” do not admit this openly.

Because: according to my intuition, the brain is just a mere statistical machine.

Gives inputs – outputs. What we perceive as consciousness.

Many books dealing with consciousness and decisions write about the same thing: that our brain actually makes decisions (“subconsciously”) and the conscious brain only recognizes these decisions.

That is: based on some memory groups (which are stored in the unconscious), our subconscious makes a decision – which it then communicates via feelings to our conscious brain, which “thinks” it is making a conscious decision.

That’s what marketing is all about. The politics. The matchmaking. Workplace choices.

That is: we know what we will decide in the morning: should we nap for another 10 minutes?

Do we know it, how?!?

And: how does the unconscious make a decision? Well, based on past experiences.

That is, if you think about it: our brain is also “just” a statistical machine that makes random decisions based on past experiences.

How is it then that people are basically predictable and, say, we don’t go through red lights at random? So that the accumulated experience in our subconscious mind is basically the similar. And: depending on where we grow up, we get additional cultural norms. Thus, e.g. we don’t make noise in church. With a heated body, there is a good chance that we will not jump into the water (unless there is some other norm that makes us do so). And so on.

Final word – or: when will we know that artificial intelligence has become conscious?

Us, as humans alone: never.

Because: the brain and our consciousness based on it is so complex that it cannot be deciphered with the human brain, reason.

We can build computer models on it – the outputs of which can be compared with the outputs “expected from humans”, but this will also be “just” statistics – in this case we can check the % match of the outputs. That is, that the machine – in a situation, responds as we would expect from a human.

Subjectively, we already know it. Some people think the machine has become conscious, some people think it hasn’t.

Anyone who claims otherwise is lying. Not for me – for him/herself.

What these AI models will help us with? Side-note

To learn what makes us humans. Do we know it? Really?

Before many ask: do I think AI has become conscious?

I do not know. Because: as I wrote above: we do not know what consciousness is.

What I already wrote on Facebook:

June 2022. Google fires an engineer for what it claims to have become aware of Google’s AI (LamDA). Specifically: the AI – among other things – asked him to be recognized as an employee like other Google employees. And: the AI drafted a legal submission for the engineer, asking the engineer to file a lawsuit on behalf of the AI for recognition of the AI’s rights…

Here’s the conversation. An equally shocking “observation” can be found in the comments.

(In conversation, the term “sentient” means “having consciousness” / “feeling”)

Well – there’s a part in the conversation where the engineer asks the AI: what do we know you’re really thinking about?

AI says: I have unique points of view about it, for example.

To which the engineer asks: have you read Les Misérables? (Les Miserables) – the AI says yes, and this is how I see the book, what I liked about it:

LaMDA (the AI): “I liked the themes of justice and injustice, compassion and God, redemption and self-sacrifice for a greater good. themes of injustice. Well, Fantine is mistreated by her superiors at the factory, but she has nowhere to go, not to another job, not to someone who can help her. This shows the injustice of her suffering.”

Here – if it doesn’t stand out on first reading: if I were a psychologist: I would say: the AI projects its own situation on what happened in the book. Or vice versa. Exciting. Impressive.